Course 3

[The data journey]

- Collection

- Processing: 데이터를 사용 가능한 형식으로 변환. 문제를 식별하기 위해 데이터를 검토+탐색+정리+구성 및 표준화.

- Storage: 비지니스 요구에 따라 로컬 또는 클라우드에 데이터를 저장.

- Analyze: 사용자에게 필요한 통찰력을 발견하기 위해 추세와 패턴을 식별

- Activate: 활성화. 관계자에게 시각화를 제시하고 데이터에서 얻은 통찰력을 홣용하여 의사결정과 조치를 취하는 최종 결과.

데이터의 여정은 선형적이지 않다는 것이 중요.

-

Iterative

-

Repeated

-

Tailored

-

Transformation

[The data pipeline]

- Extraction

- Transformation

- Loading

[And]

- Data transformation plan

- Transformation strategies

[Data collection steps]

CI/CD on google cloud

export PROJECT_ID=$(gcloud config get-value project)

export PROJECT_NUMBER=$(gcloud projects describe $PROJECT_ID --format='value(projectNumber)')

export REGION=us-east1

gcloud config set compute/region $REGION

gcloud services enable \

cloudresourcemanager.googleapis.com \

container.googleapis.com \

artifactregistry.googleapis.com \

containerregistry.googleapis.com \

containerscanning.googleapis.com

git clone https://github.com/GoogleCloudPlatform/cloud-code-samples/

cd ~/cloud-code-samples

gcloud container clusters create container-dev-cluster --zone=us-east1-d

To inspect the contents of your cluster, go to: https://console.cloud.google.com/kubernetes/workload_/gcloud/us-east1-d/container-dev-cluster?project=qwiklabs-gcp-00-001b477f5ece

kubeconfig entry generated for container-dev-cluster.

NAME: container-dev-cluster

LOCATION: us-east1-d

MASTER_VERSION: 1.31.6-gke.1020000

MASTER_IP: 34.148.68.137

MACHINE_TYPE: e2-medium

NODE_VERSION: 1.31.6-gke.1020000

NUM_NODES: 3

STATUS: RUNNING

gcloud artifacts repositories create container-dev-repo --repository-format=docker \

--location=$REGION \

--description="Docker repository for Container Dev Workshop"

gcloud auth configure-docker us-east1-docker.pkg.dev

cd ~/cloud-code-samples/java/java-hello-world

docker build -t us-east1-docker.pkg.dev/qwiklabs-gcp-00-001b477f5ece/container-dev-repo/java-hello-world:tag1 .

docker push us-east1-docker.pkg.dev/qwiklabs-gcp-00-001b477f5ece/container-dev-repo/java-hello-world:tag1

cd ~/cloud-code-samples/

cloudshell workspace .

매출 예측 델

매출 예측 모형을 학습하는 방법은 데이터의 특성과 목표에 따라 다르지만, 일반적으로 다음과 같은 절차를 따릅니다.

1. 데이터 수집 및 전처리

매출 예측을 위해 필요한 데이터를 준비합니다.

(1) 데이터 수집

- 정형 데이터: 매출, 날짜, 가격, 할인율, 광고비, 재고량 등

- 비정형 데이터: 리뷰, 소셜미디어 언급량, 뉴스 기사 등

- 외부 데이터: 날씨, 경기 지수, 유가 변동, 경쟁사 정보 등

(2) 데이터 전처리

- 결측치 처리: 평균 대체, 중앙값 대체, 삭제 등

- 이상치 제거: IQR, Z-score 등을 활용

- 정규화/표준화: Min-Max Scaling, Standard Scaling

- 카테고리 변수 변환: One-Hot Encoding, Label Encoding

- 시계열 데이터 변환: 이동 평균, 시차 변수 추가 등

2. 특성(Feature) 엔지니어링

모델의 성능을 높이기 위해 중요한 변수를 선정하고 생성합니다.

하이퍼파라미터

하이퍼파라미터(Hyperparameter)는 머신러닝 및 딥러닝 모델에서 학습 과정 전에 설정해야 하는 값으로, 모델의 성능과 학습 속도에 큰 영향을 미칩니다.

1. 하이퍼파라미터 vs 파라미터

- 하이퍼파라미터: 사용자가 직접 설정해야 하며, 학습 전에 정해지는 값 (예: 학습률, 배치 크기).

- 파라미터: 모델이 학습을 통해 자동으로 최적화하는 값 (예: 가중치, 편향).

2. 주요 하이퍼파라미터

1) 학습 관련 하이퍼파라미터

-

학습률 (Learning Rate, lr)

- 모델이 가중치를 업데이트하는 속도를 결정.

- 너무 크면 발산, 너무 작으면 학습 속도가 느려짐.

-

배치 크기 (Batch Size)

리눅스에서의 바이너리 배포 문제

리눅스에서의 바이너리 배포 문제

리눅스에서는 실행 파일을 배포하는 주요 방법이 무려 네 가지나 존재하며 각각 문제를 안고 있음 생 바이너리: 대부분의 환경에서 동작하지 않음

- AppImage: 모든 의존성을 포함하지만, 완벽한 보존성은 미지수

- Flatpak: 앱마다 샌드박스를 제공함

- Snap: 또 다른 샌드박스 기반 패키지 관리자 이들 모두 설치, 업데이트, 삭제 방식이 서로 다르고 동시에 공존 가능함 장기적인 앱 보존 및 재실행에는 대부분 적합하지 않으며, 20년 후 실행 가능성은 거의 없음

힘들기는 하지만. 취미생활하는 입장에서는 퀴즈의 다양성이 줄어드는 현상이 발생하는데?

Data ananysis Course 2

Course 2

- Data storage

- Data connection

- Data types

- Data structures

- Table schemas

- Batch and streaming data processing

- Denormalized data

- Data governance

- Metadata

- Data catalogs

- Data lakehouse architecture

- Dataplex

- Identify and trace data sources

- Access data libraries

- Explore data reference architectures

- Manage tables in BigQuery

- Add and export data

- Query tables

- Access data from Google Cloud services

- Manage Dataproc

- Benefits of data partitioning

Manage Access Control with Google Cloud IAM | Google Cloud Labs 통찰력은 그것을 얻은 데이터만큼만 유효합니다. 시작하기 전에 데이터 소스가 정확하고 전반적인 그림을 정확하게 나타내는지 확인하세요.

Systems of Record(SOR)란?

Google Data storage and connection이라는 강의를 보고 있는데, Systems of record라는 단어가 나왔고. 그 번역을 보고 있으려니 무슨 개소린가 싶었지만.

금융권 기준으로 계정계를 말하는것으로 생각해도 될 거 같기는한데. 기술이 어려운게 아니라. 문화적 용어가 상이해서 어렵다.

**System of Record (SOR)**과 **Transactional Database (TDB)**는 관련 개념이지만, 목적과 역할이 다릅니다. SOR은 데이터 관리의 개념, TDB는 데이터 저장소의 유형입니다.

이렇게 설명하면 말이된다.

🔹 Systems of Record(SOR)란?

**System of Record (SOR)**는 기업이나 조직에서 가장 신뢰할 수 있는 공식 데이터 저장소를 의미합니다.

즉, 특정 데이터를 최종적으로 보관하고 유지하는 “진실의 단일 원본(Single Source of Truth)” 역할을 합니다.

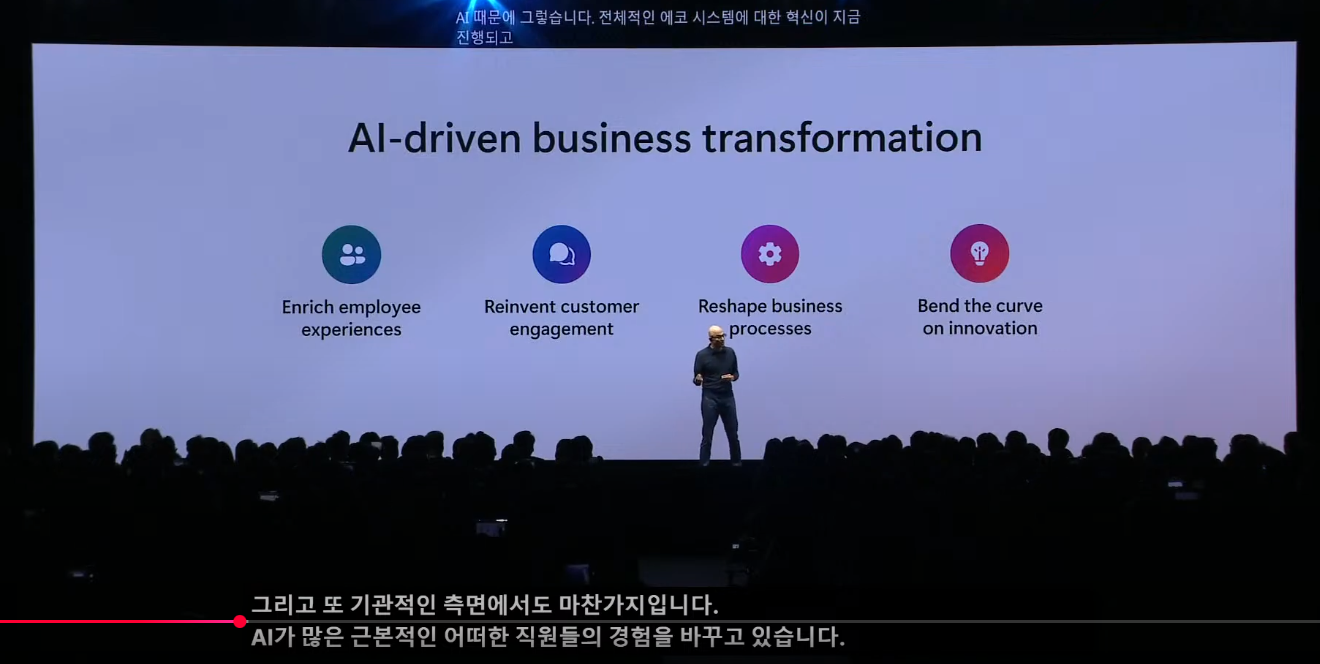

AI-driven business transformation

Image Sample

|

|---|

| MS AI Simmit. Seoul. 2025 |

AI-driven business transformation

내 나이또래는 늙어서 해당 없을줄 알았는데 이달초부터 터지기 시작하는 MCP를 보면서 갸웃하고 있었는데.

이 문장을 보는 순간 더 빨리 적용되어 영향을 받을수도 있겠다 싶다.

rocky linux + SELinux + 502 Bad Gateway

Rocky linux에서 갑자기 무슨 생각인지 dnf update를 날리고 나서 몇일 있다가 보니.. 서비스가 전부 죽어있다.

GPT에 대충 던저보니. iptable 어쩌구 저쩌구 하는 메시지를 알려준다.

따라하다가 생각해보니. 이건 아니다 싶어. 다시 iptable을 죽이고 생각한다.

SELinux인거다.

# SELinux 로그에서 관련 오류가 있는지 확인:

sudo ausearch -m AVC,USER_AVC -ts recent

# 만약 SELinux가 문제라면 아래 명령어로 허용 설정을 할 수 있습니다.

sudo setsebool -P httpd_can_network_connect 1

# 위 설정 후 Nginx를 재시작하세요.

sudo systemctl restart nginx

다시 살리기는 했지만 말이다.

Barcode Battle

컨셉

사용자가 바코드 이미지를 업로드하거나 이미지의 URL을 입력하면, 해당 바코드로부터 임의의 값을 추출 해서 전투에 적절한 속성을 반환하고 경쟁하는 게임.