Below you will find pages that utilize the taxonomy term “Ai”

BigQueryML에서 TRANSFORM

BigQueryML에서 TRANSFORM은 모델 학습 전에 데이터 전처리를 선언적으로 지정할 수 있는 기능입니다. 이를 통해 훈련/예측 시 일관된 전처리 파이프라인을 적용할 수 있으며, 특히 파이프라인 재사용이나 자동 특성 엔지니어링에 유용합니다.

✅ 기본 개념

BigQueryML의 TRANSFORM 구문은 CREATE MODEL 문에서 사용되며, 주로 다음과 같이 구성됩니다:

CREATE MODEL project.dataset.model_name

TRANSFORM (

-- 변환 정의

)

OPTIONS (...) AS

SELECT ...

🔧 예제: 범주형 인코딩 + 스케일링

CREATE OR REPLACE MODEL my_dataset.my_model

TRANSFORM (

one_hot_encoded_country AS

one_hot_encode(country),

scaled_age AS

standard_scaler(age)

)

OPTIONS (

model_type = 'logistic_reg',

input_label_cols = ['label']

) AS

SELECT

country,

age,

label

FROM

my_dataset.training_data;

one_hot_encode(country): 범주형 변수 인코딩standard_scaler(age): 평균 0, 표준편차 1로 정규화TRANSFORM블록에서 정의된 컬럼은 아래SELECT의 컬럼을 전처리하여 학습에 사용됨

🧠 지원되는 주요 변환 함수

| 함수 | 설명 |

|---|---|

one_hot_encode(col) |

범주형 변수 → 원-핫 인코딩 |

log(col) |

로그 변환 |

normalize(col) |

0~1 정규화 |

standard_scaler(col) |

표준화 (Z-score) |

bucketize(col, boundaries) |

수치형 변수 → 구간화 |

clip(col, min, max) |

값 제한 |

cast(col AS TYPE) |

형변환 |

📌 참고 사항

TRANSFORM은 모델 정의 내부에서만 사용 가능합니다.SELECT쿼리에서는 사용 불가합니다.TRANSFORM블록의 출력 컬럼명은 모델이 학습에 사용하는 특성명입니다.SELECT절에서는 원본 컬럼을 제공해야 합니다. (전처리는TRANSFORM안에서 수행됨)

🔍 예제: 날짜 파싱 및 로그 변환

CREATE OR REPLACE MODEL my_dataset.sales_model

TRANSFORM (

log_price AS log(price),

day_of_week AS EXTRACT(DAYOFWEEK FROM DATE(timestamp))

)

OPTIONS (

model_type = 'linear_reg',

input_label_cols = ['sales']

) AS

SELECT

price,

timestamp,

sales

FROM

my_dataset.sales_data;

필요하다면 TRANSFORM 없이도 SQL로 사전 전처리를 해서 CREATE MODEL에 넘길 수 있지만, TRANSFORM을 쓰면 학습-예측 간 일관성이 보장됩니다.

rmse가 낮다는 것은 어떤 의미인가?

RMSE(Root Mean Square Error)가 낮다는 것은 다음과 같은 의미를 갖습니다:

✅ 1. 예측 정확도가 높다

- RMSE는 예측값과 실제값 사이의 평균적인 오차 크기를 나타냅니다.

- 따라서 RMSE가 낮다는 것은:

- 모델의 예측값이 실제값과 더 가깝다는 뜻이고,

- 모델이 정확한 예측을 하고 있다는 것을 의미합니다.

✅ 2. 큰 오차가 적다

- RMSE는 오차를 제곱해서 평균을 내기 때문에, 큰 오차일수록 더 큰 패널티를 받습니다.

- 따라서 RMSE가 낮다는 것은:

- 단순히 평균 오차가 작은 것뿐 아니라,

- **큰 오차(이상치)**가 별로 없다는 의미도 됩니다.

✅ 3. 모델이 과적합(Overfitting)되지 않았을 수 있다

- 훈련 데이터에서 RMSE가 낮고, 검증 데이터에서도 낮다면 → 모델이 잘 일반화되었다는 신호입니다.

❗주의할 점

- RMSE는 단위에 민감하므로, 다른 모델들과 비교할 때는 반드시 같은 단위/데이터 기준에서 비교해야 합니다.

- RMSE만 보고 성능을 판단하는 것은 위험할 수 있으니, MAE, R², 잔차분석 등과 함께 보는 것이 좋습니다.

예시로,

Overfitting

좋은 질문입니다!

모델 학습(Machine Learning Training) 과정에서 자주 듣는 “Overfitting (오버피팅)“에 대해 명확히 설명드릴게요.

🎯 Overfitting(오버핏)이란?

모델이 학습 데이터(training data)에 너무 과하게 맞춰져서, 새로운 데이터(test/unseen data)에는 잘 일반화되지 못하는 현상입니다.

즉,

- 학습 데이터에서는 정확도가 매우 높지만,

- 실제로 새로운 데이터에 적용하면 성능이 급격히 나빠지는 문제입니다.

🚀 쉽게 예를 들면

- 학생이 기출문제만 외워서 시험을 치면 기출에는 만점이지만,

처음 보는 문제는 전혀 못 푸는 것과 비슷합니다.

(공부를 “문제의 패턴"을 이해한 게 아니라 “문제 자체"만 외운 거죠.)

One-hot Encoding이란?

좋습니다, 간단하고 확실하게 정리해드릴게요!

🎯 One-hot Encoding이란?

One-hot Encoding은

범주형 데이터(categorical data)를 수치형 벡터로 변환하는 기법입니다.

특징:

- 각 범주(category)는 고유한 벡터로 표현됩니다.

- 이 벡터는 대부분 0이고, 해당하는 범주 위치만 1입니다.

예시

예를 들어, “과일” 데이터가 있다고 해볼게요:

| 과일 | |

|---|---|

| 사과 | |

| 바나나 | |

| 포도 |

이를 one-hot encoding하면:

| 과일 | One-hot Encoding |

|---|---|

| 사과 | [1, 0, 0] |

| 바나나 | [0, 1, 0] |

| 포도 | [0, 0, 1] |

- 사과는 첫 번째 칸만 1

- 바나나는 두 번째 칸만 1

- 포도는 세 번째 칸만 1

왜 필요한가요?

- 모델(특히 신경망) 은 수치 입력만 처리할 수 있습니다.

- 범주형 데이터를 고유 숫자로 변환하면 모델이 **“수치 간 크기 비교”**를 할 수 있다고 잘못 해석할 수 있습니다.

- One-hot은 이런 왜곡 없이 범주 간 평등한 거리를 유지시켜줍니다.

PyTorch / TensorFlow 코드 예시

Python 코드 (간단하게)

Adaptive Layers란?

좋은 질문입니다!

“Adaptive Layers” 를 깔끔하게 설명해드릴게요.

Adaptive Layers란?

Adaptive Layers는

학습이나 추론 과정에서, 모델이 자동으로 “특정 층(layer)“을 조정하거나 최적화하는 구조를 뜻합니다.

쉽게 말하면,

모델이 상황에 따라 필요한 층만 사용하거나,

가중치(weight)를 조절하거나,

특정 레이어만 업데이트하는 식으로 유연하게(adaptive) 작동한다는 거예요.

어디에 사용되나요?

- Transfer Learning (전이 학습)

- Fine-Tuning (미세 조정)

- Parameter-Efficient Tuning (예: LoRA, Adapter)

- Large Language Models (LLMs) 의 경량화 튜닝

Adaptive Layers의 주요 개념

| 개념 | 설명 |

|---|---|

| Layer Freezing | 기존 모델의 대부분 레이어는 “고정(freeze)“하고, 일부 레이어만 “학습(adapt)“하게 함. |

| Adapter Layers | 기존 모델 사이사이에 “얇은” 적응 레이어를 끼워서 학습량을 줄이는 방법. |

| LoRA (Low-Rank Adaptation) | 기존 큰 가중치 행렬을 작은 행렬로 근사해서 적응시키는 방법. |

| Routing | 입력에 따라 다른 레이어를 동적으로 선택하는 방법. (예: Mixture of Experts) |

예시 1: Transfer Learning에서의 Adaptive Layers

- 예를 들어, 큰 모델(BERT 등)을 가져와서,

- 초반 레이어는 고정시키고,

- 마지막 몇 개 레이어만 새 데이터에 맞게 조정할 수 있습니다.

- 이때 마지막 몇 개 층이 Adaptive Layers처럼 작동하는 거죠.

예시 2: Adapter Layers (구체적)

- 기존 모델의 모든 가중치를 그대로 둔 채,

- 중간중간에 작은 Adapter Layer를 삽입합니다.

- 학습은 Adapter Layer만 합니다.

- 이렇게 하면 모델을 가볍고 빠르게 튜닝할 수 있습니다.

context drift

아주 좋은 질문입니다.

이런 현상은 “drift” 또는 특히 “context drift” 혹은 “attention drift” 라고 부릅니다.

구체적으로 설명하면:

- LLM (대규모 언어 모델) 은 대화가 길어질수록,

- 초기에 설정된 목표나 톤, 문맥을 점점 잃어버리는 경향이 있습니다.

- 처음과 끝은 비교적 집중이 잘 되어 있지만,

중간부에서는 일관성 부족 또는 품질 저하가 발생할 수 있습니다.

이런 문제를 가리켜:

| 용어 | 의미 |

|---|---|

| context drift | 대화 문맥이 점차 흐트러지거나 변질되는 현상 |

| attention drift | 모델이 초반 초점에서 점차 다른 주제나 스타일로 주의가 흐트러지는 현상 |

| generation degradation | 긴 응답/대화 세션에서 점차 품질이 저하되는 일반적인 현상 |

왜 이런 현상이 생기나?

- LLM은 “현재까지의 입력” 만을 보고 매번 다음 토큰을 예측합니다.

- 대화가 길어질수록 초기 정보(시작 컨텍스트) 의 영향력이 줄어들 수 있습니다.

- 또한 메모리 한계(컨텍스트 윈도우 크기) 때문에,

과거 정보가 부분적으로 잘리거나 희석되면서 drift가 심해집니다.

예시

- 초반: 주제를 정확히 따라감

- 중간: 세부 정보가 틀리거나, 약간 다른 방향으로 새어 나감

- 끝: 마무리할 때 다시 처음 목표로 끌어오는 경향이 있음

정리

장시간 LLM 사용 시, 중간에 응답 품질이 떨어지는 현상은

“Context Drift”, “Attention Drift”, 또는 포괄적으로 “Generation Degradation” 이라고 부릅니다.

RMSE

좋아요!

RMSE에 대해 추가로 자세히 설명해드릴게요:

RMSE란?

- RMSE는 Root Mean Squared Error의 약자입니다.

- “평균 제곱 오차의 제곱근” 을 뜻합니다.

- 쉽게 말하면, 모델이 예측한 값과 실제 값 사이의 오차(틀린 정도) 를 숫자 하나로 요약한 지표입니다.

왜 쓰나요?

- RMSE는 오차가 클수록 벌점이 커지게 설계되어 있어서,

예측이 많이 틀린 경우를 민감하게 감지할 수 있습니다. - 그래서 정확한 모델을 만들고 싶을 때 RMSE를 줄이는 걸 목표로 합니다.

수식 (조금 수학적으로 보면)

[ \text{RMSE} = \sqrt{ \frac{1}{n} \sum_{i=1}^{n} (예측값_i - 실제값_i)^2 } ]

GCP console 명령

gcloud config set project qwiklabs-gcp-00-acf9d7b837de

export GOOGLE_CLOUD_PROJECT=$(gcloud config get-value core/project)

gcloud iam service-accounts create my-natlang-sa \

--display-name "my natural language service account"

gcloud iam service-accounts keys create ~/key.json \

--iam-account my-natlang-sa@${GOOGLE_CLOUD_PROJECT}.iam.gserviceaccount.com

gcloud compute ssh [INSTANCE_NAME] --zone=[ZONE]

gcloud compute ssh linux-instance --zone=us-east4-b

gcloud ml language analyze-entities --content="Michelangelo Caravaggio, Italian painter, is known for 'The Calling of Saint Matthew'." > result.json

export API_KEY=<YOUR_API_KEY>

export API_KEY=AIzaSyCO4c7jJCH-ZaMGAld9KLbLUBbrVgpsauI

touch request.json

nano request.json

{

"config": {

"encoding":"FLAC",

"languageCode": "en-US"

},

"audio": {

"uri":"gs://cloud-samples-tests/speech/brooklyn.flac"

}

}

curl -s -X POST -H "Content-Type: application/json" --data-binary @request.json \

"https://speech.googleapis.com/v1/speech:recognize?key=${API_KEY}"

curl -s -X POST -H "Content-Type: application/json" --data-binary @request.json \

"https://speech.googleapis.com/v1/speech:recognize?key=${API_KEY}" > result.json

ML

과거의 application 개발에서는 modal window라고 불렀는데, 이것과 멀티모달의 모달이 같은 의미인가?

아주 날카로운 질문이에요! 결론부터 말하면:

✅ “멀티모달(Multimodal)“의 모달과

✅ “모달 윈도우(Modal Window)“의 모달은

❌ 의미가 완전히 다릅니다! 단어는 같아 보여도 어원과 맥락이 전혀 달라요.

🧠 1. **멀티모달(Multimodal)**의 “모달”

- 여기서 modal은 **“mode” (양식, 방식)**에서 파생된 단어입니다.

- 의미: 정보의 양식 (text, image, audio, 등)

- 어원: 라틴어 modus → “방식, 형식”

예:

- 멀티모달 AI = 여러 종류의 데이터 방식(텍스트, 이미지 등)을 다루는 AI

🪟 2. **모달 윈도우(Modal Window)**의 “모달”

- 여기서 modal은 **“모드에 따른 행동 제한”**에서 나옵니다.

- 의미: 사용자의 인터랙션을 특정 윈도우에 잠시 강제하도록 만드는 UI 모드

- 예: 팝업창이 떠 있을 때 그걸 닫기 전까지는 뒤 창을 클릭할 수 없음

“모달 윈도우"란?

현재 뜬 창과만 상호작용이 가능하고, 다른 UI 요소는 잠시 비활성화되는 상태

→ 이 창을 닫기 전까지 다른 작업 불가능 (즉, 모드 전환이 일어난 상태)

화투게임 + ML

화투 게임 동영상을 학습해서 점수를 계산한 모델이 있나?

지금 질문하신 건 상당히 흥미로운 주제예요!

화투 게임(고스톱) 동영상을 인공지능이 분석해서 점수를 계산하거나 상황을 인식하는 모델이 있느냐는 질문인데, 결론부터 말하면:

✅ 현재까지 공개된 수준에서는 “정식으로 완성된 모델"은 드뭅니다.

하지만 가능성은 충분하고, 연구나 개인 프로젝트로 진행된 사례는 일부 존재합니다.

🔍 왜 어려운가?

화투 게임은 다음과 같은 복합적 인식이 필요합니다:

- 영상에서 카드 인식 (작고, 복잡한 문양)

- 카드의 종류 판별 (광, 피, 띠 등)

- 현재 플레이 상황 분석 (누가 어떤 카드를 냈는지 추적)

- 룰 적용해서 점수 계산 (고도 복잡함: 고, 흔들기, 총통, 쪽, 따닥 등)

💬 즉, 단순한 카드 인식 → 상황 인식 → 규칙 적용 → 점수 계산까지

여러 AI 기술이 연계되어야 하기 때문에 꽤 복잡한 멀티모달 AI 시스템이 필요해요.

AI Lifecycle

[라이프사이클]

- Data: Data ingestion > Data analytics > Data engineering > to AI

- AI: Model training > Model testing > Model deployment > to Data

[구분]

- Predictive AI: 예측 AI

- Generative AI: 생성형 AI

[Supervised vs. Unsupervised]

- Supervised: Labeled data Classification: 사진에 나온 것이 고양이인지 개인지 구분. 로지스틱 회귀같은 것으로 해결 Regression: 숫자형 변수를 예측하는 회귀. 과거 판매를 바탕으로 제품 매출을 예측. 선형회귀 같은 것으로 해결.

- Unsupervised: Unlabeled data Clustering. 비슷한 특성을 같는 데이터 포인트를 그룹화. 고객인구통계를 사용해 고객 세분화를 결정. k-평균 클러스터링 같은 것으로 해결. Association: 연결로 기본관계를 식별. 식료품 매장의 경우 두 제품의 상관관계를 파악하여 시너지 효과를 위해 서롭 가깝게 배치. 사용자는 연결 규칙 학습 기술, Apriori와 같은 알고리즘을 사용하여 연결문제 해결. Dimensionality reduction: 차원축소. 데이터 세트의 차원 또는 특성의 개수를 줄여 모델의 효율성을 향상. (예)연령, 교통 규정 위반 이력, 자동차 유형과 같은 고객 특성을 결합하여 보험 견적을 생성하는 것. 주요 구성요소 분석(principal component analysis) 같은 방식으로 해결.

위 분류를 기준으로 BigQuery에서 제공하는 모델을 선택하고, 데이터를 입력해서 바로 학습시킬수 있음. (예)구매예측.

Generative AI vs. LLM

생성형 AI는 텍스트외에 다앙한 유형의 콘텐트를 생성하는 더 넓은 범위의 모델을 포괄하는 반면, LLM은 생성형 AI 모델의 한 유형으로 언어 작업에 특화된 모델을 의미.

생성형 AI:

- 생성 모델을 사용하여 텍스트, 이미지, 기타 데이터를 생성할 수 있는 인공지능의 한 분야이며 주로 프롬프트에 응답합니다.

- 입력된 학습 데이터에서 패턴과 구조를 학습한 후 유사한 특성을 가진 새로운 데이터를 생성합니다.

- LLM의 학습원리와 학습목적. LLM은 대규모 범용 언어 모델로 선행 학습 후 특정 목적에 맞게 미세 조정이 가능. 이때 대규모란 경우에 따라 페타바이트급에 달하는 학습 데이터 세트의 규모와 파라미터 수를 의미. 파라미터는 머신이 모델 학습을 통해 학습한 메모리와 지식. 파라미터는 텍스트 예측 등 모델의 문제 해결 능력을 결정하며 그 수는 수십억에서 수조 개에 이름. 범용이란 모델이 일반적인 문제를 충분히 해결할 수 있다는 뜻. 이는 작업의 종류와 무관하게 적용되는 인간 언어의 공통성 때문.

- LLM이 선행 학습되고 미세 조정되었다고 하면 이 모델이 대규모 데이터 세트를 사용해 범용으로 선행 학습된 후 특정 목표에 맞게 더 적은 데이터 세트로 미세 조정되었음을 뜻함.

- LLM의 학습: LLM에 프롬프트를 제출하면 선행 학습된 모델에서 정답의 확율을 계산함. 이 확율은 선행 학습이라고 불리는 작업을 통해 결정됨. 선행 학습은 방대한 텍스트, 이미지, 코드 데이터 세트를 모델에 피드하는 것으로 모델이 이 언어의 기본 구조와 패턴을 익힐 수 있게 함. 이 프로세스를 통해 모델은 인간의 언어를 효과적으로 이해하고 생성하게 됨. 이처럼 LLM은 고급형 자동 완성 기능처럼 작동하면서 프롬프트에 대해 가장 일반적인 정답을 제안함.

프롬프트 엔지니어링:

매출 예측 델

매출 예측 모형을 학습하는 방법은 데이터의 특성과 목표에 따라 다르지만, 일반적으로 다음과 같은 절차를 따릅니다.

1. 데이터 수집 및 전처리

매출 예측을 위해 필요한 데이터를 준비합니다.

(1) 데이터 수집

- 정형 데이터: 매출, 날짜, 가격, 할인율, 광고비, 재고량 등

- 비정형 데이터: 리뷰, 소셜미디어 언급량, 뉴스 기사 등

- 외부 데이터: 날씨, 경기 지수, 유가 변동, 경쟁사 정보 등

(2) 데이터 전처리

- 결측치 처리: 평균 대체, 중앙값 대체, 삭제 등

- 이상치 제거: IQR, Z-score 등을 활용

- 정규화/표준화: Min-Max Scaling, Standard Scaling

- 카테고리 변수 변환: One-Hot Encoding, Label Encoding

- 시계열 데이터 변환: 이동 평균, 시차 변수 추가 등

2. 특성(Feature) 엔지니어링

모델의 성능을 높이기 위해 중요한 변수를 선정하고 생성합니다.

하이퍼파라미터

하이퍼파라미터(Hyperparameter)는 머신러닝 및 딥러닝 모델에서 학습 과정 전에 설정해야 하는 값으로, 모델의 성능과 학습 속도에 큰 영향을 미칩니다.

1. 하이퍼파라미터 vs 파라미터

- 하이퍼파라미터: 사용자가 직접 설정해야 하며, 학습 전에 정해지는 값 (예: 학습률, 배치 크기).

- 파라미터: 모델이 학습을 통해 자동으로 최적화하는 값 (예: 가중치, 편향).

2. 주요 하이퍼파라미터

1) 학습 관련 하이퍼파라미터

-

학습률 (Learning Rate, lr)

- 모델이 가중치를 업데이트하는 속도를 결정.

- 너무 크면 발산, 너무 작으면 학습 속도가 느려짐.

-

배치 크기 (Batch Size)

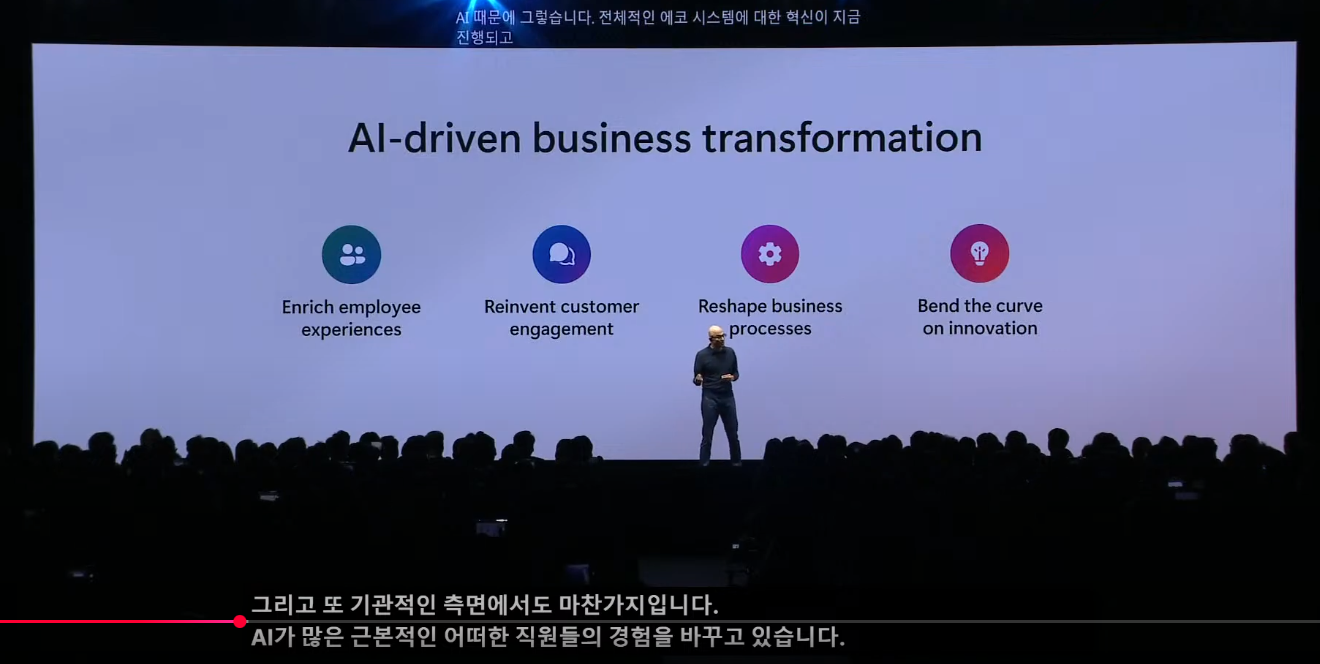

AI-driven business transformation

Image Sample

|

|---|

| MS AI Simmit. Seoul. 2025 |

AI-driven business transformation

내 나이또래는 늙어서 해당 없을줄 알았는데 이달초부터 터지기 시작하는 MCP를 보면서 갸웃하고 있었는데.

이 문장을 보는 순간 더 빨리 적용되어 영향을 받을수도 있겠다 싶다.

Barcode Battle

컨셉

사용자가 바코드 이미지를 업로드하거나 이미지의 URL을 입력하면, 해당 바코드로부터 임의의 값을 추출 해서 전투에 적절한 속성을 반환하고 경쟁하는 게임.

Develop GenAI Apps with Gemini and Streamlit Skill Badge

evelop GenAI Apps with Gemini and Streamlit Skill Badge은 사실 Streamlit에 혹해서 시작해본 녀석이었으나 진행을 해보니 Docker build하고 deploy하는 과정이었다.

requirements.txt

처음 제공되는 requirements.txt에 2개가 빠져있는데, 아무생각없이 pip로 설치만 했다가, 나중에 docker deploy하고 나서 테스트하는 과정에서 없다고 나와서 지우고 새로 올리는 사태가 벌어졌다.

pip install google.cloud-logging

pip install vertexai

# requirements.txt에 빠진내용

pip freeze > requirements.txt

# 나중에 docker build 할 때 requirements.txt 사용된다는 점을 생각하자.

export 변수명

중요하게 사용되는것은 project와 region인데.. 물론 다 하드코딩으로 하면 전혀 문제될 것이 없겠지만, 치환해서 사용하려면, 좀 보고 주의를 기울여야 한다.

GData ananysis Module 1

[Data lifecycle]

Introduction to the data management

-

회사가 사용자에 대한 데이터를수 수집한다고 가정.

-

모든 사용자가 전체 데이터에 접근 할 수 있다면 재앙이 됨. –> Data Management

-

Data Management는 수집, 저자으 활용에 대한 명확한 계획을 수립하고 전달하는 과정

-

각 단계에 대한 처리과정을 모든 직원이 이해할수 있도록 계획수립. == 데이터 거버넌스라고도 부름.

- 원할한 협업이 보장. 문서화된 절차에 따라 데이터에 엑세스 할 수 있음으로. 데이터는 거버넌스 및 규정 준수 요구사항 내에서 유지.

- 데이터 보안 프로그램 지원. 데이터 침해나 데이터 손실을 방지하기 위한 매개변수를 설정하는데 도움.

- 명확한 절차를 갖추어 확장성을 높이는데 도움.

-

고려 핵심 측면.

PGVector

postgres를 사용하면서 개발 생성하는 user에 superuser role을 부여하지는 않았었는데, vector extension을 사용할려고 보니 부여하는게 간편하다.

SELECT * FROM items ORDER BY embedding <-> '[3,1,2]' LIMIT 5;

Supported distance functions are: <-> - L2 distance <#> - (negative) inner product <=> - cosine distance <+> - L1 distance <~> - Hamming distance (binary vectors) <%> - Jaccard distance (binary vectors)

지원되는 거리측정 표현이다.

Automation Bias

GPT와 같은 도구를 사용 할 때 항상 의심하라는 생각을 하게된다.

그리고 그 의심을 전제하지 않은 사용자가 만약 지인이라면 그것을 전제 하도록 이야기 해 줘야하는 것 아닐까?

**자동화 편향(Automation Bias)**은 사람들이 자동화된 시스템(예: AI, 알고리즘, 자동화 도구 등)의 결과나 권고를 지나치게 신뢰하고, 이에 대한 비판적 사고나 추가적인 검증을 소홀히 하는 경향을 의미합니다.

📌 자동화 편향의 주요 특징

- 과도한 신뢰: 자동화 시스템이 항상 정확하고 오류가 없다고 가정하는 경향이 있음.

- 검증 부족: 사람이 직접 데이터를 확인하거나 추가적인 판단을 내리지 않고 자동화된 결과를 그대로 수용함.

- 실수 간과: 자동화 시스템이 오류를 발생시켜도 이를 인지하지 못하거나 중요하게 여기지 않음.

- 의사 결정 능력 저하: 지속적으로 자동화된 시스템에 의존하면 사람의 독립적인 사고와 판단력이 약화될 수 있음.

🚨 자동화 편향의 예시

- 의료 진단: AI 기반 진단 시스템이 잘못된 판단을 내렸을 때, 의사가 이를 검토하지 않고 그대로 환자에게 적용하는 경우.

- 자동 조종 장치: 항공기 조종사가 자동 조종 시스템을 지나치게 신뢰하여, 이상 상황에서도 직접 개입하지 않아 사고가 발생하는 경우.

- 금융 거래: 알고리즘 기반 주식 거래 시스템이 오류를 일으켜도, 투자자가 이를 믿고 추가적인 검토 없이 매매를 진행하는 경우.

✅ 자동화 편향을 줄이는 방법

- 이중 검토(Double-Checking): 자동화 시스템의 결과를 사람이 직접 검증하는 절차 마련.

- 비판적 사고 강화: 자동화된 결정이 항상 옳다고 가정하지 않고, 지속적으로 의문을 갖고 분석하는 습관 기르기.

- 교육 및 훈련: 사용자가 자동화 시스템의 한계를 이해하고 올바르게 활용할 수 있도록 교육 제공.

- 책임 분배: 중요한 의사 결정에서는 사람이 최종적으로 판단을 내리는 구조를 유지.

자동화는 효율성을 높여주지만, 맹목적으로 의존하면 오히려 문제가 될 수 있어요. 따라서 자동화 시스템을 활용하되, 항상 사람의 개입과 검증을 병행하는 것이 중요합니다. 😊

AI. 단어들 그리고 용어들

손실함수

Transformer 모델에서 손실 함수를 사용하는 이유는 모델이 학습하는 동안 예측과 실제 값 간의 차이를 정량적으로 측정하고, 이를 바탕으로 모델을 최적화하기 위해서입니다.

Machine learning vs. Deep learning

assets/images/2025-03-18-01-01.png

Transfer model은 Deep learning model인가?

A Transformer model is a type of deep learning model designed for sequence-to-sequence tasks such as natural language processing (NLP). It was introduced in the paper “Attention Is All You Need” by Vaswani et al. (2017) and has since become the foundation for many state-of-the-art models like BERT, GPT, and T5.

Prompt의 종류

Google Cloud Skills Boost를 따라 해 보고 있다.

Prompt를 진행하다 보니 단어가 몇 가지 보인다.

- Zero-shot prompt

- One-shot prompt

- Few-shot prompt